原文:A Large-scale Robustness Analysis of Video Action Recognition Models

什么是视频时序行为识别(VAR)?

VAR就是理解视频中人(或其他)的行为,涉及到识别、定位和预测行为等任务。目前相关的研究可以理解为图像分类的进阶版本:视频分类。其可以应用场景包括:行为分析,视频检索,人机交互,游戏娱乐等等。

数据集:Kinetics和something系列。其构建流程如下:

- 定义action list, 即一系列行为的标签,如骑车、跳舞、爬山等等

- 通过网络爬取各个行为相关的视频

- 手动标注每个行为类别在视频中的起止时间

- 数据清洗

OK,那么我们进入正文!!!

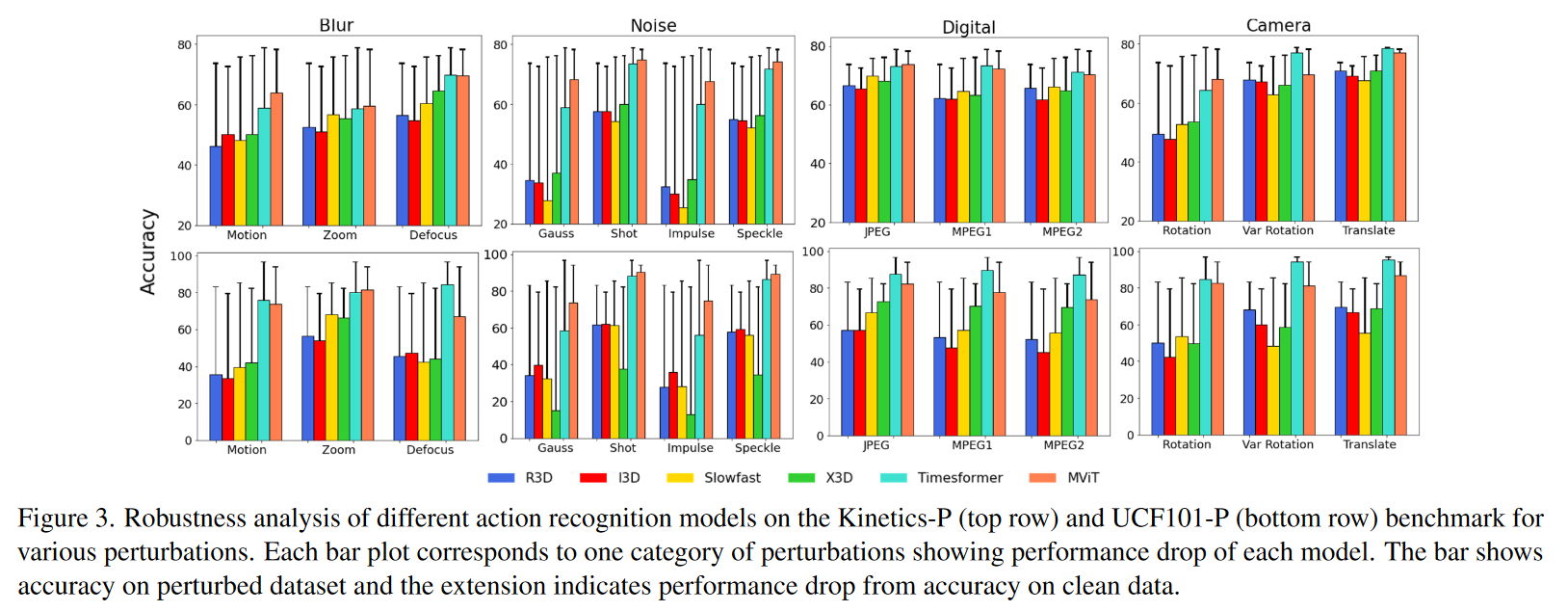

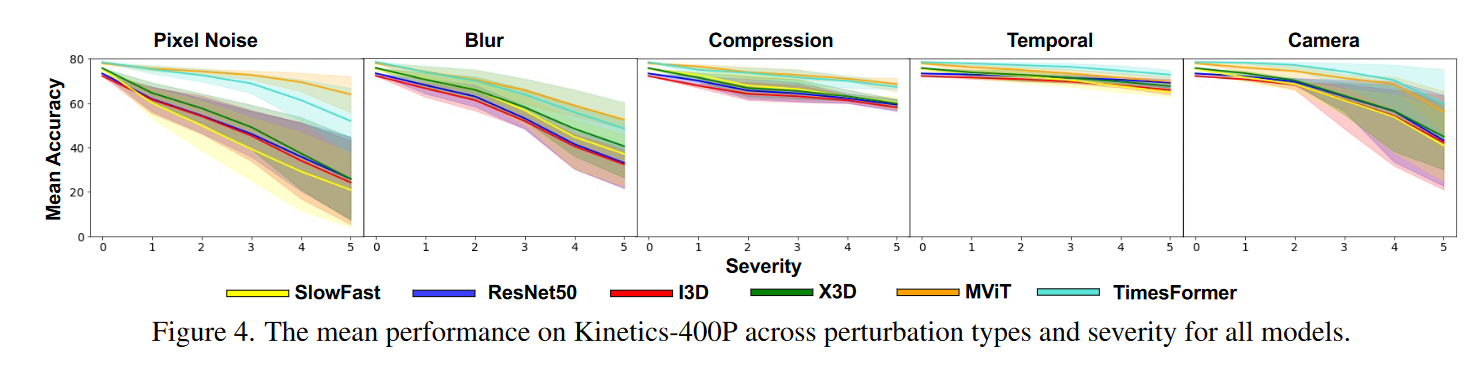

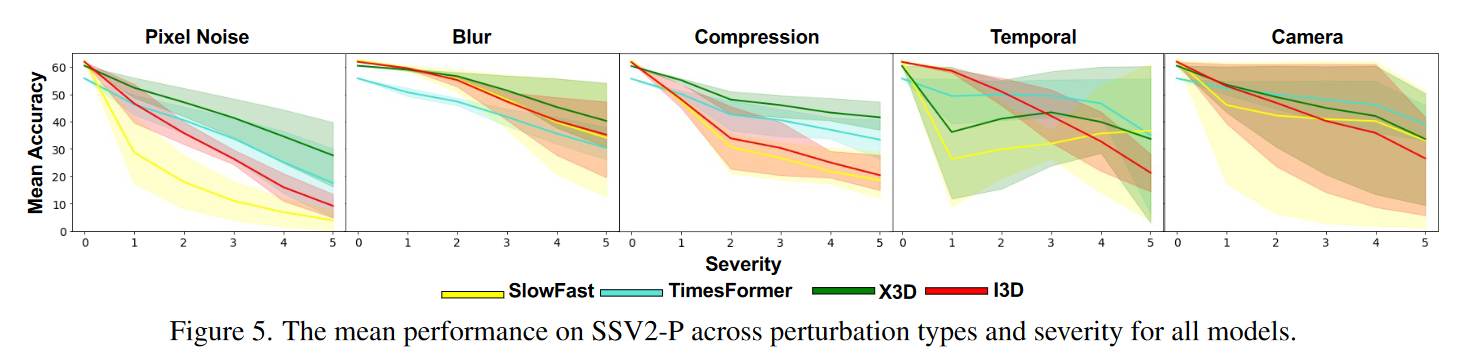

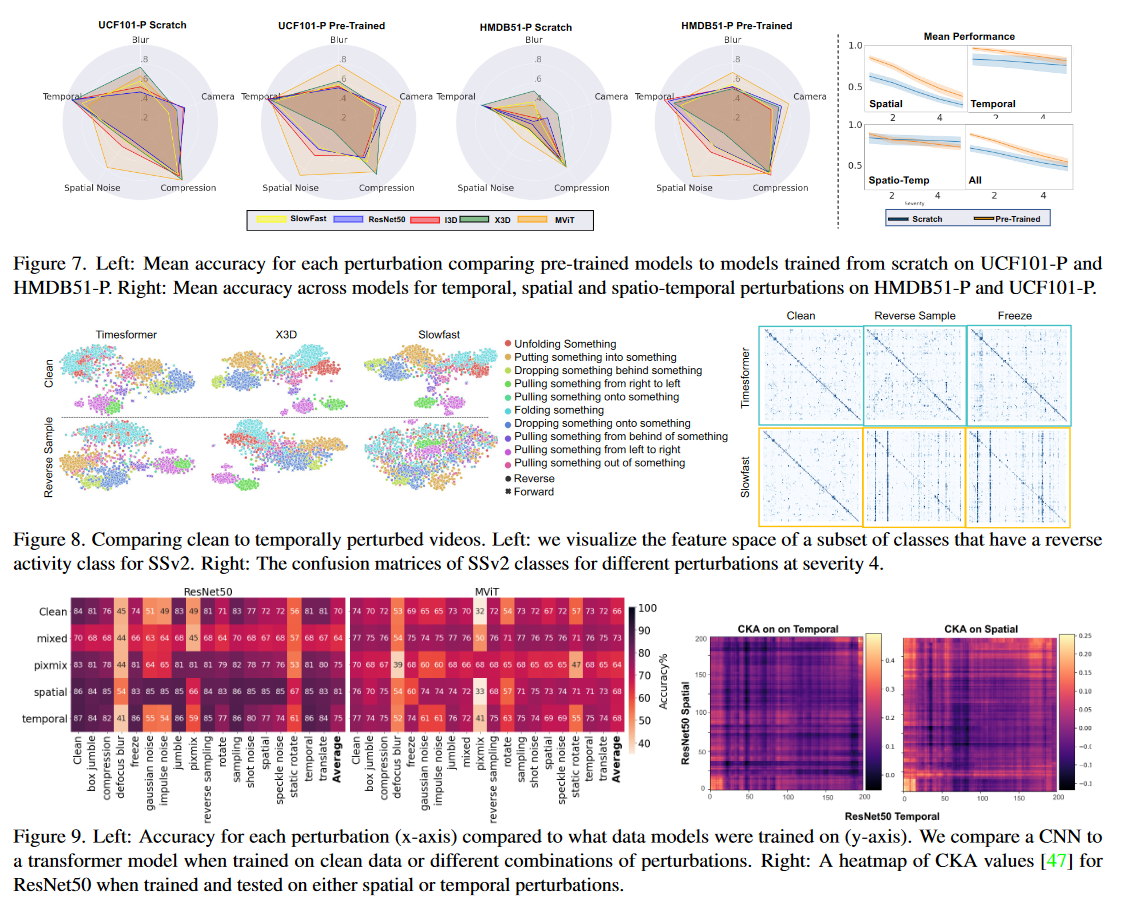

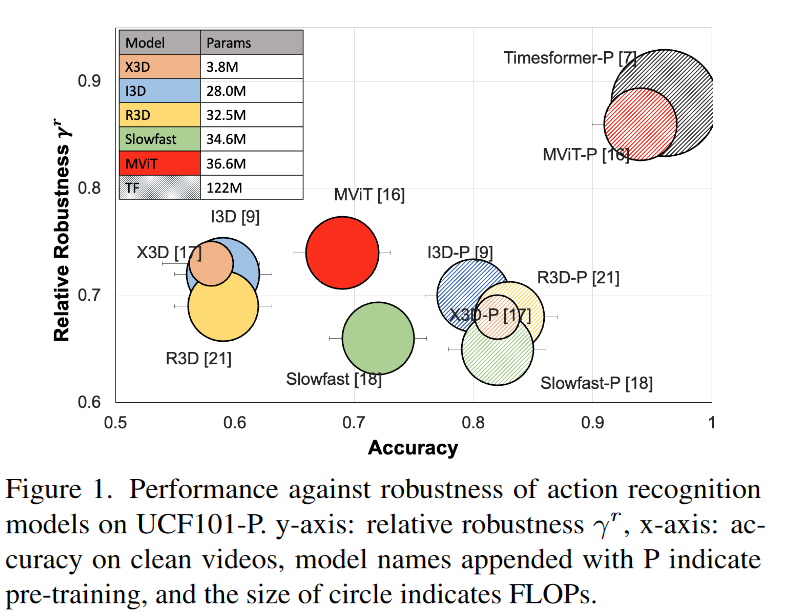

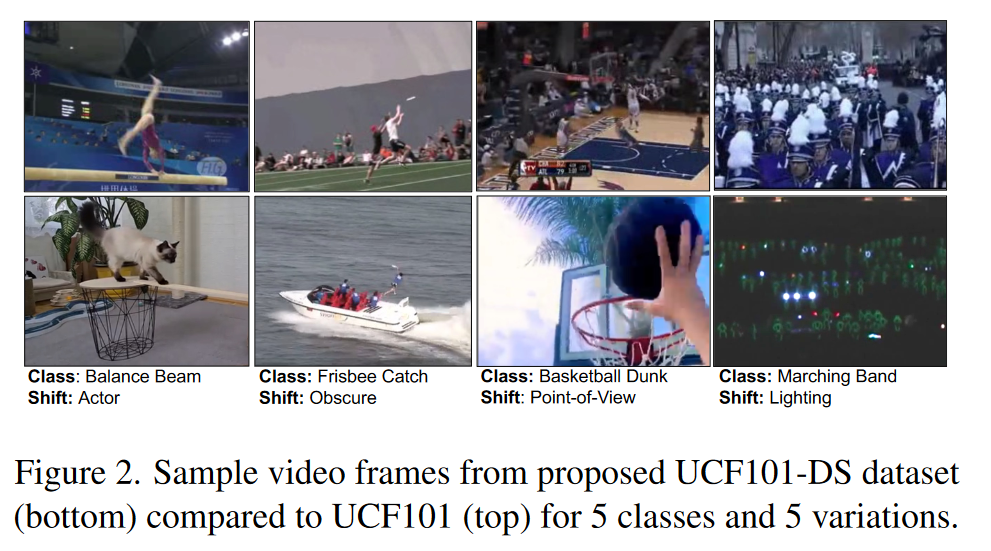

本文分析了基于CNN和基于Transformer的这两类模型的鲁棒性。相较于以前的工作大多集中于验证这些模型在对抗性攻击下的鲁棒性,本文则侧重于验证真实世界的数据分布偏差下的模型鲁棒性。

本文使用的分布漂移概述

- 噪声:本文定义了4类噪声:高斯噪声、散粒噪声、脉冲噪声和斑点噪声。高斯噪声可能由于低照明条件而出现。散粒噪声是由光的离散性质引起的电子噪声,使用泊松分布来近似它。脉冲噪声是由比特误差引起的图像质量损坏,类似于椒盐噪声。斑点噪声是相加噪声,其中相加的噪声与像素强度成比例。

- 模糊:本文为模糊效果定义了三种:缩放、运动和失焦。当摄影机快速向对象移动时,会出现缩放模糊。由于相机的不稳定运动,会出现运动模糊。当相机失焦时,可能会出现散焦模糊。

- 照片压缩:本文评估了JPEG和其他两种视频编码编解码器的模型,并分析了由于这些压缩方法导致的精度下降。JPEG是一种引入压缩伪影的有损图像压缩格式。MPEG1被设计用于压缩原始数字视频而不会造成过多的质量损失,并被用于大量的产品和技术中。MPEG2是MPEG1的增强版本,也是用于传输和各种其他应用的视频的有损压缩。

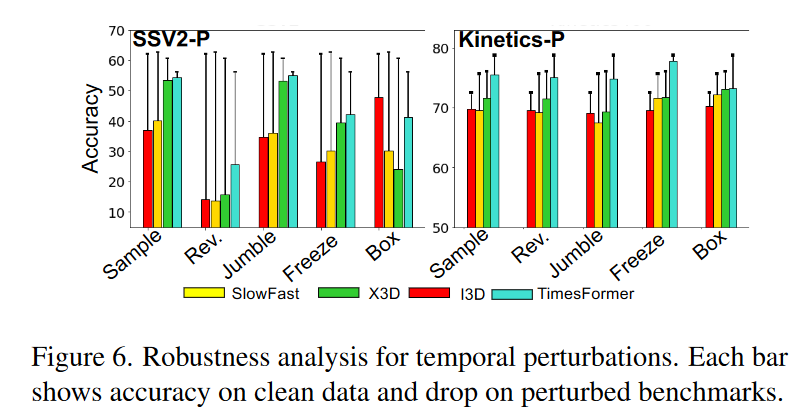

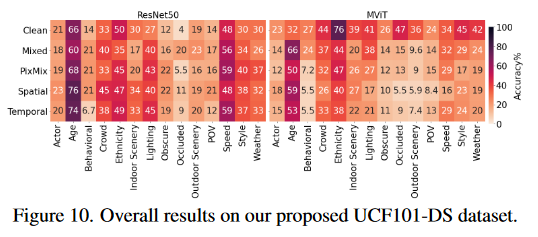

- 时间扰动:采样率、反转、抖动、盒抖动和冻结。采样率根据不同的跳过帧率来评估模型。反转扰动以不同的跳过帧速率反转视频帧。抖动以分段方式打乱帧,我们对5个不同的段大小(4,8,16,32,64)使用帧索引置换。在盒抖动中,我们打乱分段,而不是这些分段内的帧。冻结扰动随机冻结视频帧。

- 相机运动:静态旋转、动态旋转和平移。静态旋转对所有视频帧使用恒定的旋转角度。它捕捉由于倾斜的相机方向而产生的效果。随机旋转将每个帧旋转一个变化的随机角度。它捕捉由于相机角度变化而产生的效果。平移随机裁剪视频帧,裁剪位置随时间变化。

- 严重程度:我们使用了5个级别,其中1表示最小的分布偏移,5表示最大的分布偏移。

模型选择

- CNN模型

I3D: 3维卷积,Inception-V1作为骨干网络

R3D:3维卷积,ResNet作为骨干网络

SlowFast: 3维卷积,Slow和Fast双流算法,可使用任何骨干网络,本文使用ResNet.

X3D: 该模型试图优化网络大小及其复杂性。

- Transformer模型

Timesformer (TF):利用分解的时空注意力

MViT:使用池化注意力减少计算负担

鲁棒性基准数据集和验证方法

数据集

UCF101, HMDB51, Kinetics-400, and SSv2.

将上述总共90种扰动应用于这些数据集的测试集,以创建稳健性基准数据集

我们还提出了一个新的数据集,重点关注真实世界的分布变化,即UCF101-DS。对于UCF101数据集中的各个类别,我们收集了一些分布偏移不常见的视频,这些偏移被分为更高级别的组,如:“风格”、“照明”、“风景”、“演员”、“遮挡”。如下图所示。

实现细节

我们分别使用HMDB51和UCF101数据集在使用预训练权重和不使用预训练权重两种设置下训练R3D、I3D、SlowFast、X3D和MViT模型。预训练权重使用Kinetics-400训练得来。此外,由于针对SSv2数据集的I3D、Slowfast、X3D和Timesformer模型的预训练权重是公开的,我们考虑在SSv2数据集上评估这四种模型。

评估指标

为了评估鲁棒性,本文提出了绝对精度损失和相对精度损失两种评估指标。

绝对精度损失:

相对精度损失:

实验