原文:A Benchmark for Chinese-English Scene Text Image Super-resolution

一、why?

现有的工作大多集中于恢复字符结构相对简单(26个字母)的英文文本,而对于字符结构多样且复杂、更具挑战性的中文文本的研究工作较少。

二、相关研究

- SISR(single image super-resolution): SISR通过将低分辨率( LR )图像作为输入来估计高分辨率( HR )输出。传统方法通过人为设计的先验实现。最近,将卷积神经网络( CNN )用于SISR,取得了显著更好的性能。

- STISR(scene text image super-resolution): STISR侧重于场景文本图像。其目的是通过提升图像分辨率来重建文本形状,以利于下游的识别任务。TextZoom是该任务的一个基准,但该数据集只包含英文。

三、let's do it

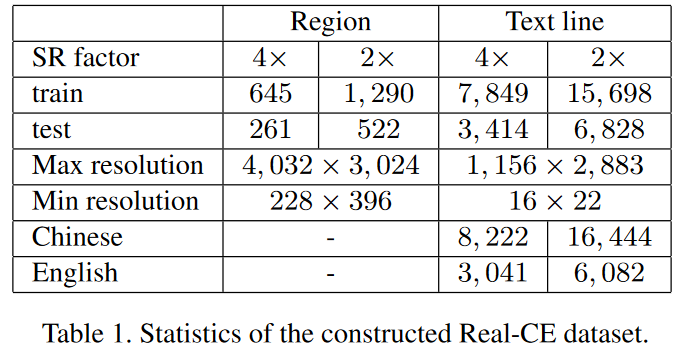

3.1 数据集构建

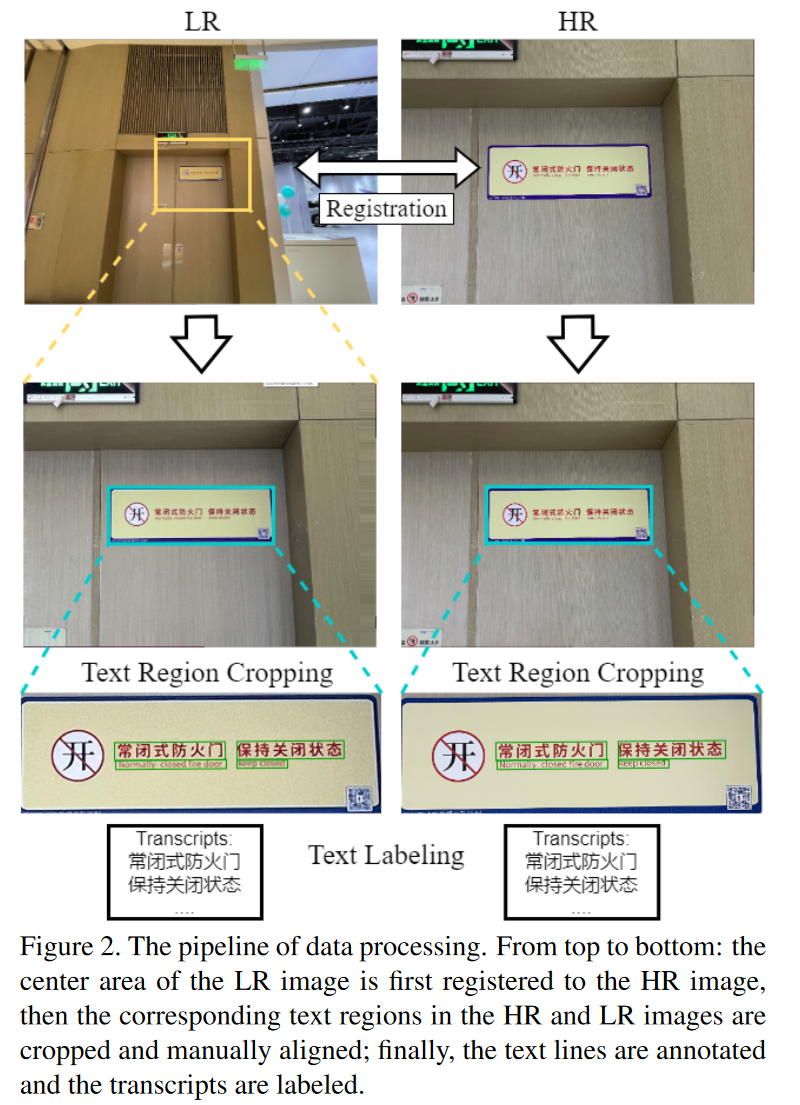

数据集的构建包括数据采集、注册(可以理解为匹配低分辨率和高分辨率的同一段文字)、文本!裁剪和文本标注四个步骤。

3.2 评价指标

- 结构相似性度量, structural similarity index measure (SSIM)

- 峰值信噪比, peak signal-to-noise ratio (PSNR)

- learned perceptual image patch similarity(LPIPS)

- normalized edit distance (NED)

- word accuracy (ACC)

四、研究方法

与英文字符不同,汉字具有更复杂的内部结构。因此,需要精心设计模型以增强中文文本重建能力。在这一部分中,我们提出了一种边缘感知学习方法,该方法使用文本边缘图作为输入,并使用边缘感知损失进行监督。

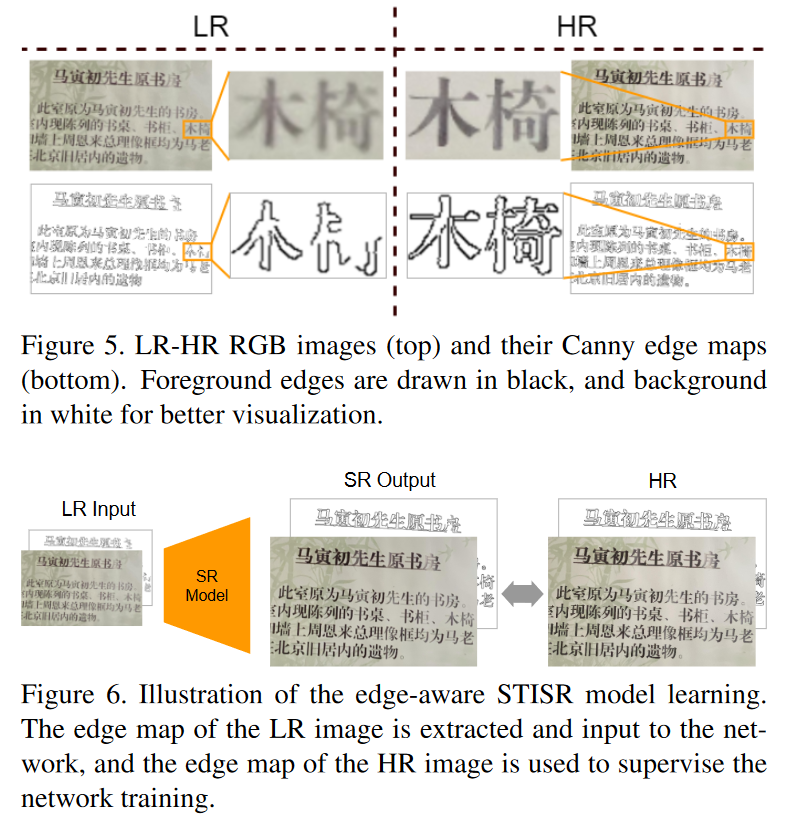

4.1 文本边缘图

使用Canny edge detector对图片进行处理,得到文本边缘图。在模型训练阶段,原始图片和文本边缘图一起输入到模型中进行训练,这里的文本边缘图起到了引导训练的作用;在预测阶段,我们只使用输出的预测图片。

4.2 边缘感知损失

首先,通过修改STISR模型,使模型输出重建的HR文本图像(

像素级EA损失:

特征级EA损失:

这里的

最后,本文损失如下:

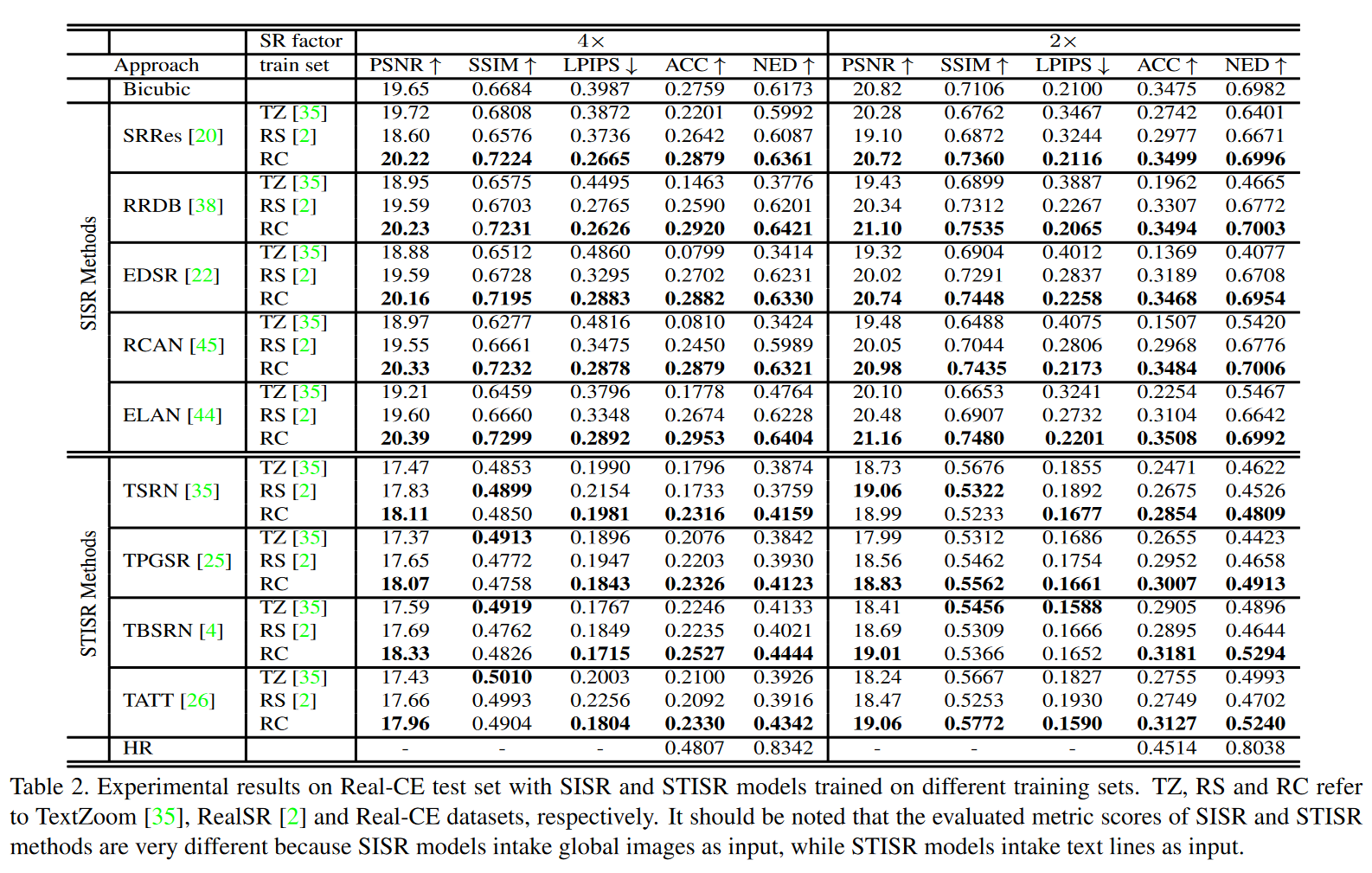

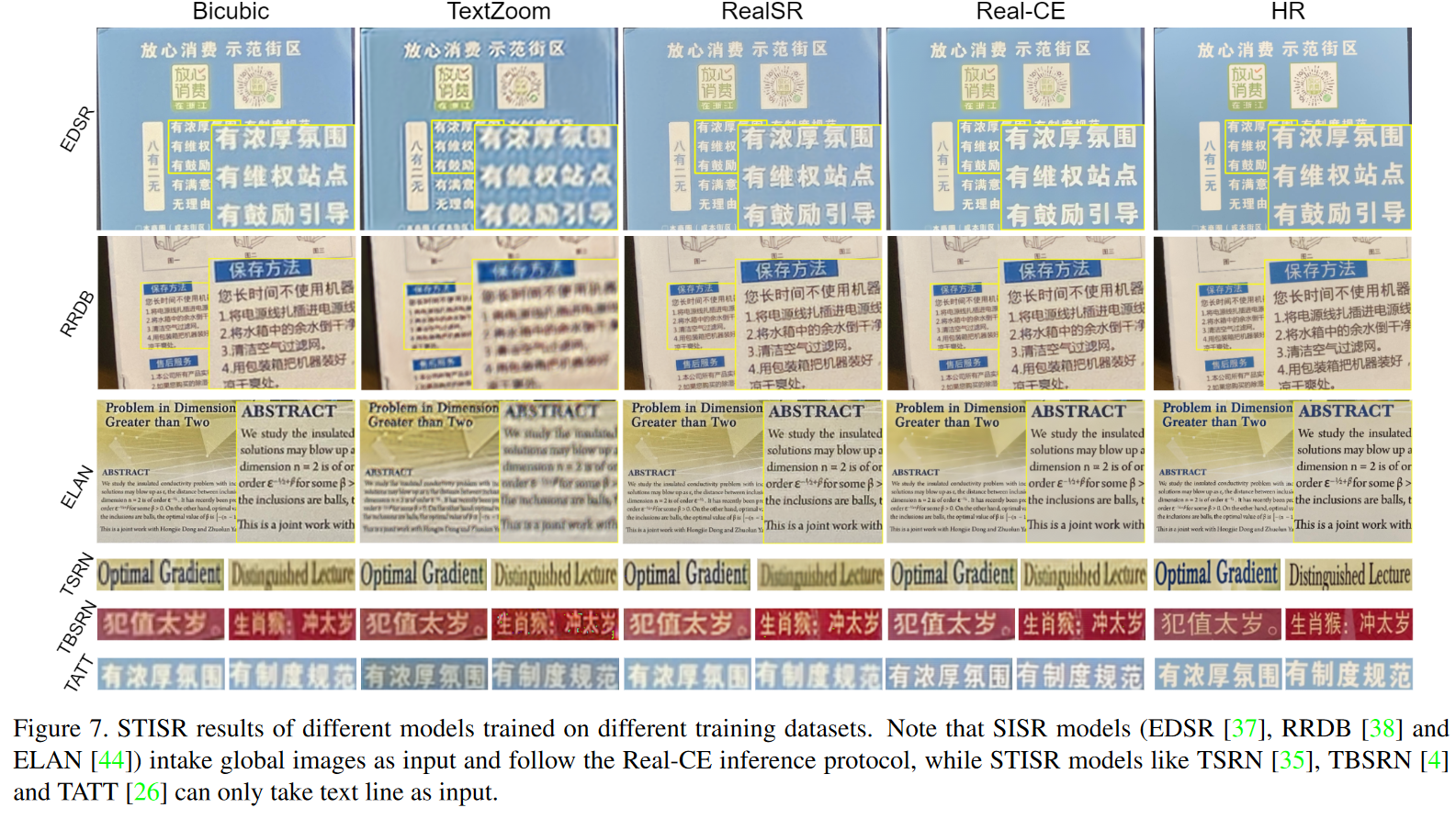

五、实验结果

5 . 1 Real-CE 数据集的有效性

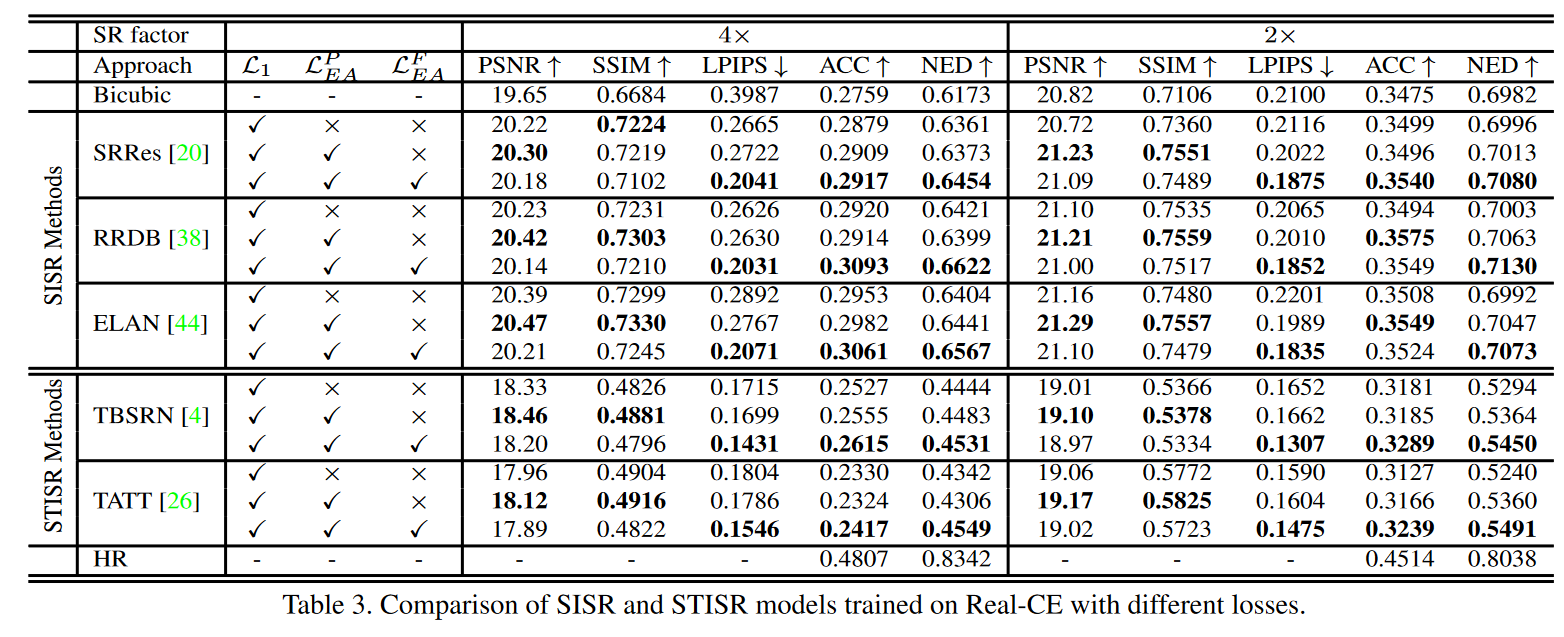

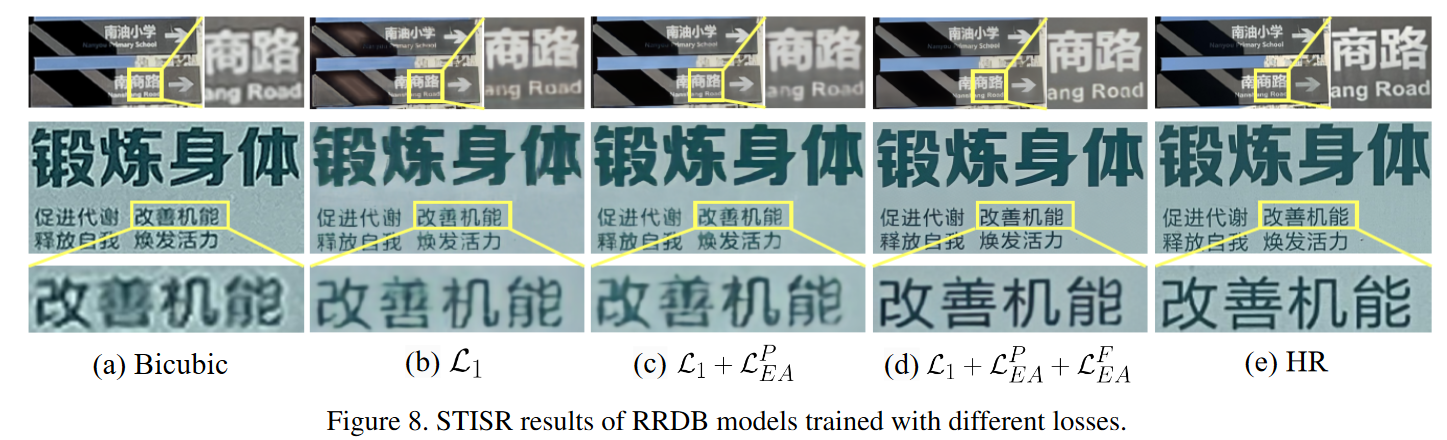

5.2 EA损失的有效性